Vorträge 2012

Prof. Peter Ulmschneider, 15. November 2012

Intelligentes Leben im Weltall, Mythos oder Realität?

Eine Begegnung der dritten Art im Universum

GIZ-Vortrag mit teilweise gewagten Thesen zu extraterrestrischem Leben

Wohl nur wenige Themen beschäftigen die menschliche Phantasie mehr, als die Frage nach der Möglichkeit von außerirdischem, intelligentem Leben. Ob es nun ETs, Klingonen, Mondo-Shiva oder Gungans

sind, sie alle flimmern mit eigenen Sprachen, seltsamen Körperbauten und eher menschlichen Zügen schon seit Jahrzehnten über Bildschirme und Kinoleinwände. In der Realität bewegt man sich mit

UFO-Theorien mehr oder weniger an der Grenze zur Parawissenschaft und Esoterik. Dabei lassen sich durchaus auch wissenschaftliche Fragestellungen zum Thema „Extraterrestrisches Intelligentes

Leben – Mythos oder Realität“ finden, die auf astronomischen und biologischen Kenntnissen und Annahmen aufbauen. An der Lösung dieser Fragen versuchte sich am vergangenen Donnerstag der in an der

US-amerikanischen Eliteuniversität Yale promovierte, emeritierte Prof. Peter Ulmschneider von der Universität Heidelberg und stellte dabei so manche gewagte These in den Raum.

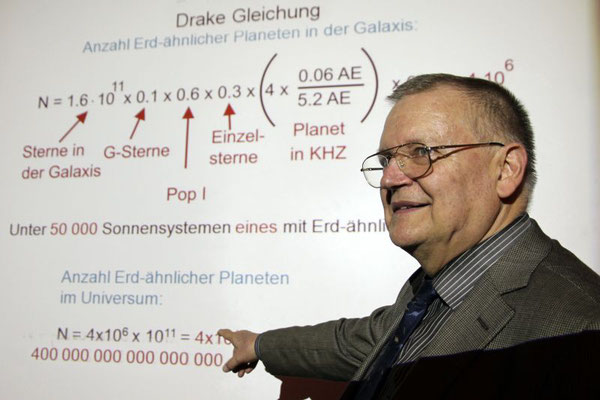

Der erste Schritt von Ulmenschneiders Überlegungen beschäftigte sich mit Berechnungen zur Wahrscheinlichkeit von erdähnlichen Planeten im Universum. Ausgangspunkt ist die Existenz der Habitablen

Zone. Dies ist der Umlaufbereich von Planeten um eine Sonne, in dem Leben prinzipiell aufgrund der klimatischen Verhältnisse auf der Planetenoberfläche möglich ist. Dazu muss einerseits die

Lebenszeit des energiegebenden Sterns lange genug reichen, um Leben hervorzubringen. Zudem müssen sich die Gezeitenwirkungen gemäßigt verhalten. Weitere Faktoren, wie der nichtlinearen

Treibhauseffekt und eine irreversible Vereisung, sind einzubeziehen. Letztendlich reduziert sich damit der Bereich um einen Stern, wie zum Beispiel unsere Sonne, auf einen Streifen um die Bahn

der Erde, der sechs Prozent des Abstandes zwischen Erde und Sonne entspricht. Dieser Bereich ist zudem nur bei ca. neun Prozent aller Sterne möglich, die der Klasse der G-Sterne angehören.

Mit diesem Wissen lässt sich abschätzen, wie viele Sterne alleine in unserer Galaxie, der Milchstraße, prinzipiell potentiell in Frage kämen, um Leben hervorzurufen. Die Gesamtzahl der Sterne in

der Milchstraße kann aus Beobachtungen auf 100 Milliarden abschätzen. Davon sind nur neun Prozent G-Sterne. Von diesen sind 60 Prozent Sterne der Population 1, was bedeutet, dass sie stabil

leuchten und aus schweren Elementen bestehen. Da meist Doppelsternsysteme auftreten, kommen von den verbleibenden Sternen nur 30 Prozent als Einzelsterne in Frage. Zusammen mit der Abschätzung

der Anzahl von Sternen mit Planeten in der Habitablen Zone, die zudem keiner Jupitermigration unterliegen, ergibt sich als Ergebnis, dass alleine in der Milchstraße vier Millionen Sterne

entsprechende Bedingungen für Leben bieten. Für das gesamte Universum gerechnet ergeben sich 400 Billiarden Kandidaten für Leben. Aus dieser unvorstellbaren Anzahl lässt sich sehr wahrscheinlich

folgern, dass das Leben auf der Erde im Universum nicht einzigartig ist.

Zu diesen astronomischen Abschätzungen lassen sich weitere biologische anstellen. So entstand das Leben in Form von Urzellen auf der Erde vor etwa 3,8 Milliarden Jahren. Vor 500 Millionen Jahren

beschritt es das Land. Vor etwa zwei Millionen Jahren entstand der Homo Erectus. Erst vor 200000 Jahren erblickte der Homo Sapiens als moderner Mensch das Licht der Welt. Somit ist das

intelligente Leben im Verhältnis zum Alter des Universums relativ jung. Trotzdem gibt es Sterne in anderen Galaxien, die schon vor 5,5 Milliarden Jahren in der Lage waren, Leben hervorbringen zu

können. Hat es eine ähnliche Evolution durchlebt, wie auf der Erde und dann als hochstehende Zivilisation allen äußeren Gefahren der Umwelt, wie Seuchen und Katastrophen, und allen inneren

Gefahren, wie Krieg und Selbstvernichtung, getrotzt, bestünde eine reale Chance für höheres, intelligentes, zivilisiertes, Milliarden Jahre altes Leben neben uns im Universum.

Prof. Hanns Ruder, 11. Oktober 2012

Schmankerl aus der Astrophysik

Gisela Pösges, 18. September 2012

Das Nördlinger Ries - eine kosmische Katastrophe formt eine einzigartige Landschaft

Der Ort an dem sich Himmel und Erde berührten

GIZ-Vortrag über den Meteoritenkrater im Nördlinger Ries

Vor etwa 15 Millionen Jahren wurde Zentraleuropa von einer unvorstellbaren Katastrophe heimgesucht. Ein Meteorit mit einem Durchmesser von ca. 1000 Metern schlug mit einer kosmischen

Geschwindigkeit von etwa 70000 Kilometern pro Stunde in die Gegend ein, wo sich heute Nördlingen befindet. Genau im Städtedreieck zwischen Nürnberg, München und Stuttgart wurde dabei beim Impakt

eine Energiemenge frei, die der von 250000 Hiroshima-Atombomben entspricht. Im Umkreis von 100 Kilometern wurde augenblicklich alles Leben dort ausgelöscht. Fetzen von Glasschmelzen aus dem

Einschlags, sog. Moldavite, flogen bis in eine Entfernung von 450 Kilometern und werden noch heute von Tschechien bis in die Lausitz gefunden. Was an der Einschlagstelle zurückblieb, war ein

Krater mit innerer Ringstruktur, der heute als Nördlinger Ries bekannt ist. Daneben schlug ein kleiner Trabant des Steinmeteoriten aus dem Asteroidengürtel einen weiteren, kleineren Krater, der

einen kleinen Zentralberg aufweist: das Steinheimer Becke. Lange Zeit wurden beide Krater für Reste erloschener Vulkane gehalten. Bohrungen und geologische Untersuchungen zeichneten aber das

völlig andere Bild, nämlich das eines Meteoriteneinschlags.

Über die spannende Erforschung des Gebiets, wo „sich Himmel und Erde berührten“, berichtete Gisela Pösges vom Zentrum für Rieskrater- und Impaktforschung Nördlingen (ZERIN) in ihrem Vortrag "Das

Nördlinger Ries - eine kosmische Katastrophe formt eine einzigartige Landschaft" am vergangenen Dienstag beim Förderverein Geodätisches Informationszentrum Wettzell e.V., der damit die neue

Vortragssaison im Herbst einläutete. Die studierte Geologin und Paläontologin arbeitet seit 1990 am Rieskratermuseum in Nördlingen und hat weltweit bereits viele Impaktreste solcher kosmischen

Zerstörungen besucht und erforscht.

Die Ursprünge der meisten zerstörerischen Bomben aus dem All ist der Asteroidengürtel zwischen den Bahnen von Mars und Jupiter. Durch Vorgänge wie zum Beispiel Zusammenstöße werden sie von ihren

ursprünglichen Bahnen abgelenkt und starten von dort ihre Reise durchs Sonnensystem. Gelegentlich kreuzen sie dabei die Bahnen der Planeten. Die Folge sind so manchmal Zusammenstöße. Dabei wurde

die Erde im Laufe ihrer Geschichte regelmäßig aus dem All bombardiert. Nachgewiesen sind aktuell 180 Krater weltweit. Auch heute finden noch gelegentlich solche Einschläge statt. Dies zeigt das

Tunguska-Ereignis des Jahres 1908, bei dem eine Region in Sibirien von der Größe des Landkreises Cham durch eine Meteoritenexplosion vernichtet wurde. Aber auch kleinere Eintritte sind noch heute

zu verzeichnen und rufen moderne Schatzjäger auf ihre Spuren, die dann nach den begehrten Himmelsboten suchen. Ein Beispiel ist der Steinmeteorit „Neuschwanstein“ aus dem Jahr 2002, von dem

aktuell drei Teile gefunden wurden. Alle drei sind momentan noch bis 21. Oktober wiedervereinigt in einer Sonderausstellung im Rieskratermuseum zu sehen.

Dabei wurden die Krater lange nicht den Gefahren aus dem All zugeordnet. Da die Überreste mit ihren unterschiedlichen Ringstrukturen oft Vulkanen ähnlich sind, wurde ihnen lange ein vulkanischer

Ursprung nachgesagt. Gleiches glaubte man auch von den Kratern auf dem Mond. Erst Eugene Shoemaker wies schlüssig nach, dass der Barringer-Krater in Arizona durch einen Meteoritenimpakt

entstanden war. Zusammen mit Edward Chao gelang ihm das bei einer Deutschlandreise im Jahre 1960 auch für das Nördlinger Ries. Dies führte dazu, dass dort sogar Astronauten der Apollo-Missionen,

wie zum Beispiel Alan Shepard, Edgar Mitchel, Eugene Cernan und Joe Engle, ausgebildet und mit Impaktgestein, das im Nördlinger Ries als Suevit bezeichnet wird, vertraut gemacht wurden. Als Dank

dafür kann heute echtes Mondgestein im Museum bewundert werden. Heutzutage belegen moderne Analysen die Existenz der Hochdruckminerale Coesit und Stishovit, wovon letzteres in der Natur nur bei

Bedingungen entstehen kann, die bei Meteoriteneinschläge auftreten. Weitere Spuren der Stoßwellenmetamorphosen sind Strahlenkegel oder „shatter cones“, die wie „Versteinerungen der enormen

Druckwelle“ die Spuren der gewaltigen Energieeintragung gespeichert haben.

Nachdem im Ries das Leben ausgelöscht war, dauerte es nur etwa 100 Jahre, bis wieder erste Lebensformen um und im mittlerweile durch salziges Wasser aus Mineralausschwemmungen gefüllten Kratersee

entstanden. Grünalgenriffe und Cyanobakterien-Kolonien haben für Wissenschaftler lesbare Spuren hinterlassen. Aber auch Pelikane, Flamingos und Schildkröten sind in Versteinerungen aus dem Gebiet

erhalten. Im Laufe der Zeit haben sich dann die Bedingungen gewandelt, der See füllte sich mit Sedimenten und Kraterwände wie zum Beispiel im inneren Ring wurden teilweise abgetragen. Trotzdem

zeugen noch heute Megablöcke, komplett zerstörte und aufgewühlte Gesteinsschichten und die verbleibenden Spuren von einer Katastrophe, die vor 14,6 Millionen Jahren ihren Lauf nahm. Wer mehr

darüber erfahren will, kann sich bei Führungen durch den Geopark Ries und im Museum detailliert in die Materie vertiefen (www.rieskrater-museum.de).

Prof. Simone Walker-Hertkorn, 3. Juli 2012

Geothermie – eine nachhaltige Energienutzung

Die Erde als riesiges Kraftwerk nutzen

GIZ-Vortrag über Geothermie als eine nachhaltige Energieform

Die Erde ist ein enormes Wärmereservoir. 99 Prozent der Erdmasse sind wärmer als 1000 Grad Celsius. Vom verbleibenden Rest sind wieder 90 Prozent wärmer als 100 Grad Celsius. Würde man diese

Energie nutzen, könnte man teilweise dem Energiehunger der Zukunft nachhaltig und trotzdem sicher entgegenwirken. Die Erdwärme oder Geothermie kann zwar nur ein Teil der Energieprobleme lösen,

doch standortbezogen angepasst ist sie klima-, umwelt- und ressourcenschonend und dennoch ökonomisch und sicher. Langfristig wird deshalb kein Weg an dieser Alternative zur klassischen

Energiegewinnung vorbeiführen.

Darüber berichtete mit fundierten Kenntnissen und zahlreichen wissenschaftlichen Fakten und Details Prof. Dr. Simone Walker-Hertkorn von der Hochschule Deggendorf in ihrem GIZ-Vortrag „Geothermie

– eine nachhaltige Energienutzung“. Als studierte Geologin betreibt sie seit 12 Jahren eine eigene Firma mit Beratung und Planung für Erdwärme-Projekte. Denn Geothermie ist in Deutschland

durchaus erfolgversprechend. „Geothermie an sich ist dabei die in Form von Wärme gespeicherte Energie unterhalb der festen Oberfläche der Erde“, wie die Professorin erklärt. Allerdings liegt der

Erfolg nicht in der Stromerzeugung, wie zum Beispiel in Island, das 98 Prozent seines gesamten Primärenergiebedarfs inklusive Heizen und Stromerzeugung über die Wärme aus der Erde deckt. In

Deutschland ist diese Energiegewinnung mehr auf die Wärmeversorgung beschränkt, an der erneuerbare Energien aktuell nur mit 10 Prozent beteiligt sind.

Ein besonderer Vorteil der Anlagen ist, dass die genutzte Technik der Wärmepumpen im umgekehrten Stil auch als Kältemaschinen genutzt werden können. So kann man im Sommer mit derselben

Installation auch kühlen. Das mach sie vor allem in gewerblich genutzten Gebäuden besonders wirtschaftlich. Aber auch im Privatbereich lohnt sich Geothermie schon heute auch ohne Subventionen und

nimmt in der Energiegewinnung einen ähnlichen Stellenwert ein wie Solaranlagen.

Zurzeit nutzt man dabei verschiedene Anlagenformen. Tiefengeothermie entzieht über Thermalwasserbohrungen Energie aus klüftigen Gesteinsformationen, produziert Fernwärme und kann teilweise

parallel, jedoch mit schlechtem Wirkungsgrad zur Stromerzeugung genutzt werden. Bei der „Hot Dry Rock“ Technik wird in ähnlicher Form erst Wasser in den Boden gepresst, um es später wieder

erwärmt zu entnehmen. Die gesellschaftliche Akzeptanz dieser Technik ist jedoch wegen der möglichen Auslösung kleiner Erdbeben eher gering und führte in einem Versuch in der Schweiz zum

Produktionsstopp. Für Privathäuser sind deshalb eher lokale Erdreichkollektoren oder Erdwärmekörbe erfolgversprechend. Sie entnehmen über im Boden verlegte Rohrleitungen oder Kollektoren die

Wärme, die über die Sonne ins Erdreich eingetragen wurde. Andere Techniken nutzen die Wärme des Grundwassers. Dies kühlt zwar den Boden um wenige Grad ab – in Versuchen kann man erkennen, dass

dort Schnee zum Beispiel etwa zwei bis drei Wochen später abschmilzt – ist aber trotzdem schonend und reicht, um ein Wohnhaus zu beheizen.

Allen Techniken gemein ist dabei die Nutzung von Wärmepumpen. Ein Arbeitsfluid wird dabei schon bei minus vier Grad verdunstet und nimmt dadurch über die im Boden eingebrachten Wärmetauscher

Umgebungswärme auf. Ein elektrisch betriebener Verdichter erzeugt dann aus den minus vier Grad bis zu 40 Grad, die über einen weiteren Wärmetauscher in die Heizung eingespeist werden. Die

kritische Größe ist dabei der elektrische Verbrauch des Verdichters. Heutige Geräte haben hierbei Jahresarbeitskennzahlen von 3,8. Das heißt, dass aus einem Kilowatt zugeführter Leistung in Form

von Strom 3,8 Kilowatt Heizleistung gewonnen werden. Dabei benötigt man für etwa 120 Quadratmeter Heizfläche ca. 170 Quadratmeter Kollektorfläche. Luftwärmepumpen sind hier bei geringerem

Jahreswirkungsgrad kompakter. Nach heutigem Stand muss man für die Wärmepumpe mit den Erdkollektoren mit Kosten von ca. 25000,- Euro rechnen. Dies hat sich aber laut Studien in 10 bis 12 Jahren

gegenüber einer konventionellen Heizungsanlage amortisiert. In jedem Fall ist es somit ein lohnendes Vorhaben, was auch Großprojekte, wie zum Beispiel die geothermische Versorgung der

Ganghofersiedlung in Regensburg mit ihren 140 Einfamilienhäusern, bestätigen.

Hartwig Löfflmann, 24. Mai 2012

Energiewende beginnt mit Sparen – das Sonnenhaus des Naturparks Bayerischer Wald in Zwiesel

Sonne und Sparen als Motto für zukünftige Energienutzung

GIZ-Vortrag zum Sonnenhaus des Naturparks Bayerischer Wald

Einerseits rückt die Nutzung von regenerativen Energiequellen für die zukünftige Versorgung der Menschen mit Energie immer mehr ins Bewusstsein. Doch andererseits könnte man durch Energiesparen

ebenfalls wesentlich zur Reduktion von gefährlichen Treibhausgasen beitragen. Denn was erst gar nicht produziert werden muss, trägt auch nicht negativ zur Energiebilanz bei. Mit diesen zwei

Grundgedanken und dem Ziel eines „Null-Energie-Hauses“ ging das Team um den Architekten Georg Dasch und Hartwig Löfflmann 1998 ans Werk, als es sich erste Gedanken zum Bau des Sonnenhauses als

neues Naturpark-Informationszentrum in Zwiesel machte. Nachdem erste Projektstudien die ursprünglichen Pläne optimiert hatten und entsprechende Fördergelder eingeworben werden konnten, begannen

im Jahr 2000 die Bauarbeiten. Es entstand ein diffusionsoffener Holzbau, der energetisch geschickt mit Fenster- und Wandflächen agiert und mittels Sonnenkollektoren beheizt bzw. über Photovoltaik

mit Strom versorgt wird. So braucht man für die etwa 200 Quadratmeter umbaute Fläche nur umgerechnet 1000 Liter Heizöl pro Jahr.

Darüber referierte am vergangenen Donnerstag Hartwig Löfflmann, studierter Forstwissenschaftler, Geschäftsführer und Bildungsreferent des Naturparks Bayerischer Wald, in seinem Vortrag

"Energiewende beginnt mit Sparen - das Sonnenhaus des Naturparks Bayerischer Wald in Zwiesel" des Fördervereins Geodätisches Informationszentrum Wettzell. Er wusste dabei zu berichten, dass man

am Anfang eher gegen alteingesessene Meinungen angehen musste, als diese neuartige Bauweise noch selten war. Heutzutage gibt es aber bereits viele Nachahmer, die in ähnlicher Weise ihr

Privathäuschen bauen. Dabei stecken einfache Prinzipien hinter der Energiespartechnik. Am Sonnenhaus gibt es 110 Quadratmeter Sonnenkollektoren, die an der Häuserfassade mit 80 Grad geneigt sind

und nicht wie sonst üblich flach auf dem Dach montiert sind. Dies ermöglicht die optimale Nutzung im Winter, wenn man die Wärme am meisten benötigt, was sich auch in den Messdaten der Anlage

widerspiegelt.

Ein automatisches Kippfenster und eine ausfahrbare Abschattung regeln umgekehrt im Sommer die Abkühlung des Gebäudes. Zudem dienen Erdkollektoren, im wesentlichen fünf 38 Meter lange

Polyethylenrohre in zwei Meter tiefe im Erdreich, zur Vorwärmung der Ansaugluft im Winter und zum Vorkühlen im Sommer. Ein 21000 Liter Pufferspeicher mit drei Glattrohrwärmetauschern und

11Temperaturfühlern sorgt für die Überbrückung von zwei bis drei Wochen sonnenloser Zeit. Den Rest an Wärme liefert eine Pellet-Heizung. Doch alleine die Solarthermie produziert das etwa

3,5-fache der benötigten Wärmeenergie, so dass auch noch ein Nachbarhaus mit versorgt werden kann. Die gesamte Anlage wird dabei von einem Zentralcomputer gesteuert.

Doch auch sonst ist Nachhaltigkeit das oberste Motto des Hauses. Die Wände sind in einer Sandwichbauweise aus Zellulosedämmung, Holzweichfaserplatte, Biospanplatte und Zellulosedämmplatten

aufgebaut und bieten ideale Wärmewerte auch ohne Plastikdampfsperren. Die Fenster bestehen aus Dreifachverglasung mit einer Edelgasfüllung zum besseren Wärmeschutz. Auch das Stromsparen durch

LEDs, Flachbildschirme, automatische Lichtregelung und Standby-Strom-Vermeidung tragen zur Energiereduktion bei. Zudem wurden wasserlose Urinale und wassersparende Toiletten installiert, um auch

den Wasserverbrauch gering zu halten.

Alles in allem ist das Haus, das bereits vor 10 Jahren entstand, noch heute ein Vorbild für energiebewusstes Bauen. Es ist mit seinen Ausstellungen und Infobereichen nicht nur ein

Informationszentrum für den Bayerischen Wald, sondern auch für die Umwelttechnik und Energieeinsparung.

Dr. Edgar Remmele, 19. April 2012

Der Beitrag von Biokraftstoffen zur Mobilität von morgen

E10 - Regenerative Energiequelle oder „Bioplörre“

GIZ-Vortrag über Biokraftstoffe als Treibstoffe der Zukunft

Mobil zu sein, ist aus der heutigen Gesellschaft nicht mehr wegzudenken. Sei es das Pendeln zur Arbeit, die Besorgungsfahrten zur nächsten Stadt oder Urlaubsreisen. Neben den öffentlichen

Verkehrsmitteln spielt dabei auch der Individualverkehr eine große Rolle. Schon jetzt kommen in Europa auf 1000 Menschen knapp 500 Autos. Die Prognosen für die Zukunft sagen zudem einen

besonderen Anstieg in China, Indien und dem Mittleren Osten voraus. Auch das gesamte Transportwesen zur Versorgung der Menschen basiert auf Mobilität. Dabei hat diese Mobilität aber

ihren Preis. So wurden alleine 2010 vom Verkehr in Deutschland errechnete 154 Millionen Tonnen des Treibhausgases CO2 in die Atmosphäre geblasen. Das sind knapp 19 Prozent der deutschen

Gesamtemission. Zudem wird Rohöl als Ausgangsstoff für unsere Treibstoffe nachweislich immer schwieriger zu fördern. Mittlerweile ist es deshalb nötig, schon an die technisch und wirtschaftlich

gewinnbaren Reserven heranzugehen, so dass zum Beispiel in Kanada mit extremem Aufwand und ökologisch verheerenden Folgen Ölschiefer und Sande zur Ölproduktion genutzt werden. Es werden zwar noch

unkonventionelle Ressourcen vorausgesagt, doch eine Feststellung bleibt: der Rohstoff Öl ist endlich! Weil durch die Verknappung des Rohstoffes und den damit verbundenen Kosten der Gewinnung bei

steigendem Bedarf auch die Kraftstoffpreise steigen werden, ist eine Alternative wünschenswert, die eventuell sogar im Inland zur Verfügung steht.

Über eine solche Alternative aus Biokraftstoffen referierte am vergangenen Donnerstag Dr. Edgar Remmele, Leiter für Biogene Kraft-, Schmier- und Verfahrensstoffe am Technologie- und Förderzentrum

im Kompetenzzentrum für Nachwachsende Rohstoffe in Straubing, in seinem GIZ-Vortrag „Der Beitrag von Biokraftstoffen zur Mobilität von morgen“ am Geodätischen Observatorium Wettzell. Aktuell

kennen die meisten Menschen Biokraftstoffe nur von der unsäglichen Diskussion um den Kraftstoff E10, bei dem in den herkömmlichen Kraftstoff 10 Prozent Bioethanol beigemischt werden.

Dies wurde an einem runden Tisch zusammen unter anderem mit der Autoindustrie schon 2007 beschlossen und hätte ursprünglich bereits 2009 umgesetzt werden sollen. Trotzdem kam im letzten Jahr die

Diskussion um erhöhten Verbrauch, Zerstörung des Motors, Verknappung von Lebensmitteln oder Nutzung von wertvollem Ackerboden für die Treibstoffproduktion. Dabei sind die meisten Thesen bei

Betrachtung der Fakten nicht haltbar. E10 ist im Heizwert nur 3 Prozent schlechter als herkömmlicher Treibstoff. Dies entspricht in etwa dem erhöhten Verbrauch, der durch veränderte

Strömungswerte am Auto bei geöffnetem Fenster entsteht. Nur 6,4 Prozent der weltweiten Getreideproduktion geht in die Bioethanolherstellung. Dabei fallen pro Liter 1,2 kg an Proteinfuttermittel

an, die Sojaschrotimporte für die Futtermittelindustrie reduzieren. Es gibt strenge Normen, die die Qualität und Nachhaltigkeit garantieren und streng einzuhalten sind. Schon im Jahr 1941 gab es

zudem einen Ackerflächenbedarf für die damaligen Transportmittel, bestehend aus Zugtieren, oder für pflanzliche Fette für Lampen von 36 Prozent, die damit nicht der Lebensmittelproduktion zur

Verfügung standen. Erfolgte Flächenstilllegungen zur Regulierung der Lebensmittelproduktion oder konkurrierende Nutzungen durch Straßen, Einkaufszentren, Tabak- und Kaffeeplantagen und ähnliches

tragen somit wesentlich stärker zum Verlust von Ackerböden bei.

Generell ist es zudem technisch kein Problem, effiziente Motoren für Biotreibstoffe zu entwickeln. So gab es sogar die Initiative zur Nutzung reinen Biodiesels aus Raps. Allerdings ist diese

durch die Einführung von Steuern und ähnliche Maßnahmen in den letzten fünf Jahren um 98 Prozent wieder zurückgegangen. Dies hat zu Frustrationen bei den Bauern und Ölmühlenbetreibern geführt und

nachhaltig Schaden hinterlassen. Trotz der Chancen zur CO2-Reduktion und zum Ressourcenschutz werden diese Kraftstoffe somit nur nachgefragt, wenn ein monetärer Vorteil gegeben ist. Mittelfristig

wird damit die Mobilität über eine Vielzahl verschiedener Kraftstoffe zu sichern sein. Das Beste für den Schutz von Umwelt und Rohstoffen ist aber immer noch die Einsparung, so dass die

Autoindustrie genauso gefragt ist, wie jeder einzelne. Wer mehr zum Thema erfahren möchte, kann am 17. Juni den Tag der offenen Tür am Kompetenzzentrum für Nachwachsende Rohstoffe in Straubing

nutzen.

Falko Schmidt, 15. März 2012

Desertec - Solarstrom aus der Wüste

Die Oberpfalz steht für Solarenergie aus der Wüste

GIZ-Vortrag über die zukunftsweisenden Pläne der DESERTEC Foundation

Auf den ersten Blick ist nicht sofort klar, was die Oberpfalz mit der Gewinnung von Solarenergie und dem Bau von Solarkraftwerken in den Wüsten unserer Erde zu tun hat. Diese bilden das Potential

für die Energieversorgung einer zukünftigen Weltbevölkerung von mehr als 10 Milliarden Menschen, die laut einigen Berechnungen im Jahr 2050 unsere Erde bevölkern. Hintergrund dieser zukünftigen

Energieversorgung ist eine Energiebilanz, die besagt, dass alleine die Wüsten der Erde in 6 Stunden mehr Energie von der Sonne empfangen als sie von der Menschheit in einem Jahr verbraucht wird.

Zudem leben ca. 90 Prozent der Weltbevölkerung nicht weiter als 3000 Kilometer von diesen Wüsten entfernt. Hierauf basieren die Ideen der DESERTEC Foundation, die im Jahr 2009 vom Club of Rome

und engagierten Privatpersonen gegründet wurde und zusammen mit dem Deutschen Zentrum für Luft- und Raumfahrt das DESERTEC-Konzept entwickelt hat. Es will sauberen Strom nicht nur aus der

Sonnenenergie der Wüsten, sondern auch global nachhaltige Energie aus Biomasse, Geothermie, Windkraft und Wasserkraft konzipieren und dabei die Gesamtenergiebilanz und mögliche negative Folgen im

Auge behalten. Zur Umsetzung wurde nicht nur ein DESERTEC Universitätsnetzwerk gegründet, sondern auch eine Industrieinitiative Dii GmbH für die Mittelmeerregion ins Leben gerufen, die

verschiedene zukunftsweisende und unterstützende Unternehmen zum Erreichen der Konzeptziele zusammenführt. Hier kommt schließlich auch die Oberpfalz in das Geschehen um die zukünftige

Energiegewinnung ins Spiel, werden doch fast alle weltweiten Spiegelkomponenten für solarthermische Kraftwerke von oberpfälzischen Firmen produziert und hier allen voran von der FLABEG Holding

GmbH in Furth im Wald.

Über dieses Konzept referierte am vergangenen Donnerstag Falko Schmidt von der DESERTEC Foundation, der extra zu dem Vortrag mit dem Titel „DESERTEC – Sauberer Strom aus Wüsten. Ein Konzept für

Energiesicherheit und Klimaschutz für eine Welt mit 10 Milliarden Menschen in 2050“ aus London angereist war. Unterstützt wurde er mittels eines Ausblicks in die Produktpalette der Firma FLABEG,

als im Anschluss vom Geschäftsführer der GmbH, Franz Reimer, die Produktpalette und die technischen Errungenschaften der letzten Entwicklungen aufgezeigt wurden.

Der Vortrag von Falko Schmidt beschränkte sich hauptsächlich auf die EU-MENA Region, bestehend aus Europa, Mittlerer Osten und Nordafrika. Dort sollen, laut dem Konzept, solarthermische

Kraftwerke der verschiedenen Bauarten, wie zum Beispiel Parabolrinnen, Solartürmen, Linear Fresnel oder Parabol-Schüsseln, errichtet werden. Der dort gewonnene Strom kann dann in die

Verbraucherländer transportiert werden. Die technologische Umsetzung dieser Stromleitung ist dabei mittels Hochspannungs-Gleichstrom-Übertragung bereits gelöst und wird in China schon jetzt auf

Strecken bis zu 1400 Kilometern erfolgreich eingesetzt. Erste Leitungen sind bereits zwischen Marokko und Spanien errichtet oder sollen zwischen Tunesien und Norditalien entstehen. Im Gegensatz

zu den hierzulande errichteten, dezentralen Photovoltaik-Paneelen wird bei den vorgestellten Kraftwerken jedoch die gebündelte Sonnenenergie zum Aufwärmen eines Mediums, wie zum Beispiel Öl, auf

über 400 Grad Celsius genutzt, womit schließlich Wasserdampf erzeugt und eine Turbine angetrieben wird. Dies steigert nicht nur die Effizienz, es lässt es auch zu, Energie über mehrere Stunden in

Form von Wärme in Wärmespeichertanks mit flüssigem Salz zu speichern und verzögert abzurufen. Damit lassen sich Verbrauchsspitzen z.B. in den Abendstunden überbrücken. Zukünftige Systeme sehen

zudem geschlossene Kreisläufe vor und nutzen selbstreinigende Oberflächen, so dass der Wasserverbrauch in den Wüstenregionen reduziert wird. Zum Schutz vor Unwettereinflüssen lassen sich die

riesigen Spiegel in Schutzpositionen parken und überdauern so Sandstürme und Hagelschläge. Die seit über 25 Jahren in Kalifornien in Betrieb befindlichen Anlagen belegen eindrucksvoll ihre

Langlebigkeit, die mit heutigen Technologien noch übertroffen wird.

Insgesamt ist das DESERTEC-Konzept eine Win-Win-Situation. Während in Europa die heimischen, erneuerbaren Energiequellen den Hauptbedarf zu ähnlichen Preisen wie heute liefern und mittels

Wüstenstrom in etwa von kalkulierten 18 Prozent des gesamten Verbrauchs unterstütz werden, sollen vor Ort in den Wüstenregionen neue Technologien Arbeitsplätze schaffen und

Wasserentsalzungsanlagen zur besseren Wasserversorgung betrieben werden. Dies bildet eine Chance zu einer sozio-ökonomischen Entwicklung der MENA-Länder, dient zur Friedenssicherung und

unterstützt insgesamt den Klimaschutz durch CO2-Reduktion. In jedem Fall bildet das Konzept jedoch eine sichere Energiealternative zu Erdöl, Erdgas und Atomkraft und die Oberpfalz und besonders

der Landkreis Cham liefern schon jetzt ihren sicheren Beitrag zu einer Zukunft aus regenerativen und sauberen Energien.

Prof. Udo Simonis, 16. Februar 2012

Klimawandel – Entwicklungen und Auswirkungen für Deutschland und die Welt

Gibt es Gerechtigkeit im Treibhaus Erde?

GIZ-Vortrag über den Klimawandel und politische Maßnahmen dagegen

Politik ist nicht wirklich einfach. Ganz besonders nicht, wenn es darum geht, Einschränkungen und Restriktionen durchzusetzen. Wenn diese dann auch noch globale Auswirkungen haben, ergeben sich

langwierige und komplexe Prozesse. Diese zu verstehen ist dabei ebenfalls nicht immer einfach. Dabei haben sie doch meist eine konkrete Notwendigkeit. Dies sieht man im Besonderen, wenn es um das

Thema Klimawandel geht. Jeder Mensch hat dazu seine eigene Vorstellung und Meinung. Die Wissenschaft ist hier jedoch schon etwas weiter. Sie hat bereits nachgewiesen, dass sich global die

Durchschnittstemperatur erhöht, dass die Meereshöhen steigen und dass die Schnee- und Gletscherbedeckung rapide zurückgeht seit der einsetzenden Industrialisierung. Offen ist nur, wie steil der

Trend weiterläuft. Glaubt man den Modellen, gibt es je Szenario eine Spanne von 1,4 bis 6,4 Grad Celsius zusätzlicher Temperaturerhöhung bis zum Jahr 2100 weltweit. Diese Spanne reicht damit von

geringen bis zu katastrophalen Veränderungen. Es besteht aber berechtigter Verdacht, dass die Menschheit mit einem bedrohlichen Szenario konfrontiert sein wird. Gerade hier kommt damit auch die

Politik ins Spiel, die Regularien zum Schutz vor diesen Problematiken über lange Sicht schaffen soll.

Darüber referierte am vergangenen Donnerstag ein Kenner der politischen Szene, der emeritierte Professor für Umweltpolitik, Dr. Udo E. Simonis, vom Wissenschaftszentrum Berlin. Er war extra für

diesen Vortrag mit dem Titel „Klimawandel – Entwicklungen und Auswirkungen für Deutschland und die Welt“ aus Kiel angereist und konnte den knapp 200 Interessierten im Haus des Gastes als

ehemaliger wissenschaftlicher Beirat der Bundesregierung in globalen Umweltfragen einige Einblicke in die Probleme und Interessenskonflikte der Klimapolitik geben. Ausgehend von einer

Weltumweltformel, die die Umweltauswirkung als eine Kombination aus Bevölkerungsentwicklung, internationalen Wirtschaftsniveaus und Nutzbarkeit der Technologien definiert, stellte Simonis die

aktuelle Situation und mögliche Folgen kurz dar. So ist alleine Europa aktuell mit dem 10-fachen über seiner verträglichen Belastungsgrenze bzgl. des Kohlendioxidausstoßes.

Gerade aber CO2 ist eines der am längsten wirksamen Gase im Treibhauseffekt. Es trägt zu etwa 80 % bei und bleibt am längsten im Kreislauf erhalten. Damit gilt es als Hauptsorgenkind, auch wenn

andere Gase, wie zum Beispiel Methan, wesentlich stärker wirken. Die Folge ist, dass die ausgestoßenen Mengen von heute die nächsten hundert Jahre aktiv sein und unser Klima beeinflussen werden.

Die Folgen sind wahrscheinlich Überschwemmungen auf der einen Seite (z.B. in Asien), aber auch Wassermangel und Hungersnöte auf der anderen Seite (z.B. in Afrika). Auch für Europa und die anderen

Industrienationen sieht es mit stärkeren Stürmen und Überflutungen nicht besser aus.

Auf Grundlage dieser Ausgangssituation kamen somit die Staaten zusammen und formulierten das Kyoto-Protokoll, um einen Klimarahmenkonvention und Folgeprotokolle auf mehr oder weniger freiwilliger

Basis zu definieren. 35 Staaten und die EU kamen dabei überein, die Treibhausgase durch geeignete Maßnahmen senken zu wollen. Vorgeschlagen wurden nachbarschaftliche Zusammenarbeiten,

Kooperationen zwischen Industrie- und Entwicklungsländern oder Emmissions-Zertifikatehandel. Dass dieser fromme Wunsch leider nicht so einfach umzusetzen war, zeigte sich dann Jahre später in der

Konferenz von Kopenhagen im Jahr 2009. Dort relativierten sich die Zielmarken. So wollte man nur noch Maßnahmen zur Reduktion des Temperaturanstiegs von weniger als 2 Grad Celsius auf unbestimmte

Zeit durchführen und dabei keine Verpflichtungen mehr eingehen. Zahlreiche Staaten sind zudem noch immer nicht gewillt, entsprechende Vorgaben umzusetzen.

Ein großes Problem ist und bleibt, genügend Anreize zu schaffen, die es Staaten und den darin lebenden Menschen ermöglicht, Vorteile aus einer Klimapolitik zu ziehen. Eine große Hoffnung liegt

deshalb in den kommenden Konferenzen, wie zum Beispiel die nächste in Rio de Janeiro. Der Wunsch wäre, eine ähnlich zur Weltgesundheitsorganisation WHO rechtlich kompetente Global Environment and

Development Organization zu gründen. Diese hätte eventuell dann die politischen Mittel, bei Gefahren verbindliche Leitlinien zu definieren, denn egal wie der Klimawandel sich einstellt, der

Mensch wird sich ihm anpassen müssen.

Roland Kaniuth, 19. Januar 2012

Die beiden ersten Galileo Satelliten und Ihr Weg ins All

Die Geburt von GALILEO’s ersten Zwillingen

GIZ-Vortrag über das europäische Satellitennavigationssystem GALILEO

Satellitennavigation ist aus unserem heutigen Alltag nicht mehr wegzudenken. Doch bisher musste man sich dazu als Privatanwender auf das amerikanische und vom dortigen Militär betriebene Global

Positioning System (GPS) verlassen. Deshalb strebte man seit zahlreichen Jahren in Europa ein eigenes, ziviles System an. Am 21.10.2010 um 12:30 Uhr Mitteleuropäischer Zeit war es dann

schließlich soweit: die ersten zwei Satelliten des neuen GALILEO-Systems wurden erfolgreich in ihren Orbit befördert. Für alle Beteiligten war es, als würden „Zwillinge geboren“, als nach dem

Start der Soyus-Rakete und dem erfolgreichen Platzieren der Satelliten mit der Trägerfregatte die Satelliten nach knapp vier Stunden ihre Umlaufbahn einnahmen. Seitdem senden sie nun als eine „In

Orbit Validation (IOV)“ des zukünftigen Systems ihre Navigationssignale zur Erde, um alle Funktionalitäten der Satelliten zu validieren. Diese können bereits mit geeigneten Empfängern am

Observatorium in Wettzell empfangen werden. Zudem werden ihre Bahnen dort und in der Tochterstation TIGO in Concepción/Chile mit Hilfe der Laserentfernungsmessung exakt vermessen. TIGO war sogar

die erste Station weltweit, die eine erfolgreiche Lasermessung durchführen konnte.

Über alle diese Themenbereiche und speziell die Entwicklung und den Start der neuen Satelliten berichtete Roland Kaniuth von der Gesellschaft für Raumfahrtanwendungen (GfR) des Deutschen Zentrums

für Luft- und Raumfahrt (DLR) in Oberpfaffenhofen in seinem Vortrag “Die beiden ersten Galileo Satelliten und Ihr Weg ins All“ am vergangenen Donnerstag. Die GfR betreibt in Oberpfaffenhofen das

futuristisch wirkende Galileo-Kontrollzentrum. Kaniuth, der für die Flugdynamik der neuen Satelliten zuständig ist, war deshalb nahe am Geschehen beteiligt.

Jeder der beiden Satelliten besteht aus einer Trägerplattform mit der Versorgung, dem Bordcomputer mit Telemetrie und Kommandierung und der Satellitenregelung von Temperatur, Lage und Bahn. Dazu

kommt die eigentliche „Payload“, also die Nutzlast zur Satellitennavigation, bestehend aus Atomuhren, dem Signalgenerator, Verstärkern und verschiedenen Antennen. Eine davon sendet die

Navigationssignale aus, während weitere zur Kommandierung von der Bodenstation aus dienen oder aber für den neuen Such- und Rettungsdienst vorgesehen sind. Mit letzterem können hilfesuchende

Personen weltweit ihre Standorte über Satellit an Rettungsteams melden.

Ein solcher Satellit ist etwa so groß wie ein Kleinwagen und wiegt ca. 700 Kilogramm. Seinen Strom bezieht er aus Sonnenenergie, der über Sonnenpaneele mit einer Spannweite von 14,8 Metern

gewonnen wird. Zudem hat er 76 Kilogramm des hochgiftigen, jedoch hochenergetischen Treibstoffs Hydrazin an Bord, damit er im Laufe seines geplanten, 12-jährigen Lebens seine Position korrigieren

kann. Am Ende befördert man ihn dann mit dem letzten Rest des Treibstoffs auf eine sogenannte Friedhofsbahn oberhalb des GALILEO-Orbits.

Besonders spannend war nicht nur der Bau der neuen Satelliten, sondern auch der Start. Die wegen ihrer optimalen Nutzlastverhältnisse ideal geeignete, russische Soyus-Rakete beförderte die

Satelliten vom europäischen Weltraumbahnhof in Kourou in Französisch Guyana ins All. Dazu verbrannte sie innerhalb von 9 Minuten 276 Tonnen Kerosin und Sauerstoff. Dann waren nicht nur die

Booster leer, sondern auch die beiden weiteren Stufen abgesprengt und die Schutzhülle hatte die Fregatte mit den beiden Satelliten freigegeben. Die Fregatte brachte dann mit ihren kleineren,

steuerbaren Triebwerksdüsen die Satelliten innerhalb von knapp 3 Stunden und 40 Minuten auf ihre Umlaufbahn in 23.222 Kilometern. Dort wurden sie in den folgenden 14 Tagen auf ihre Positionen mit

einem Abstand von 40 Grad positioniert. Kaniuth zeigte nicht nur anschauliche Filmaufnahmen vom Zusammenbau der riesigen Rakete und ihrem beeindruckenden Start, sondern schilderte detaillierte

Protokolle und zeigte Simulationen des Starts.

Aktuell laufen nun die Tests der Nutzlast, also der Navigationselektronik, die pro Satellit zwischen zwei und drei Monaten in Anspruch nehmen. In der zweiten Hälfte 2012 sollen dann zwei weitere

Satelliten ins All gebracht werden. Aktuell befinden sich zudem 14 weitere im Bau bei der Firma OHB in Bremen. Mit einem der beiden Kontrollzentrum in Oberpfaffenhofen ist Deutschland eine

zentrale Komponente des vom europäischen Steuerzahler getragenen Systems. Aber auch in Wettzell ist man bereit, die Vermessung der weiteren Satelliten in Angriff zu nehmen und seinen Beitrag zu

leisten.